기존 데이터센터 서버 환경에서 AI 추론 효율성 대폭 높여

GPU 중심 인프라 병목 상황에서 적절한 대안으로 손꼽혀

-

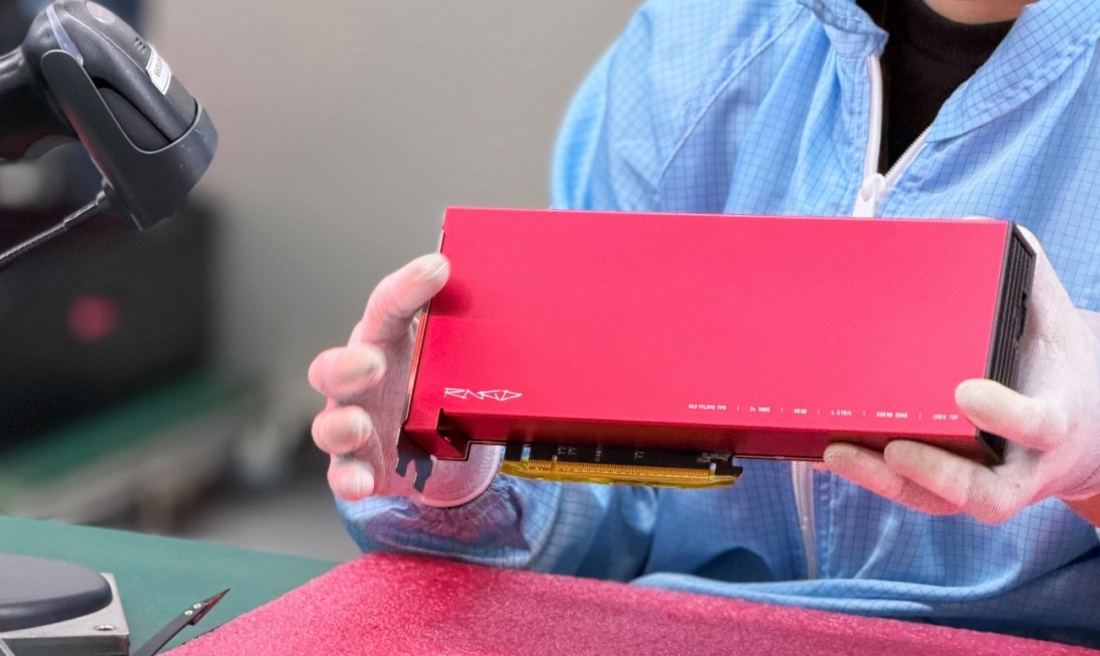

퓨리오사AI가 2세대 AI 반도체 ‘RNGD(레니게이드)’의 1차 양산 물량 인도를 시작하며 엔터프라이즈 시장 공략에 속도를 내고 있다.

이번에 출하되는 물량은 총 4000장 규모로, TSMC가 제조한 칩을 기반으로 ASUS의 카드 제조 공정을 거쳐 공급된다. 국내 AI 반도체 스타트업 가운데 고성능 NPU를 양산 단계까지 끌어올린 사례는 드물다는 점에서 업계의 시선이 쏠린다.

RNGD는 2024년 하반기 미국 스탠퍼드대에서 열린 ‘Hot Chips 2024’를 통해 처음 공개된 이후, 실제 데이터센터 환경을 전제로 한 검증과 제품화 과정을 거쳐왔다. 특히 HBM을 탑재한 고성능 AI 전용 반도체가 연구·시연을 넘어 상용 양산에 진입했다는 점에서 글로벌 반도체 업계에서도 의미 있는 사례로 평가된다.

제품 구성은 두 가지다. RNGD PCIe 카드는 180W 수준의 소비전력으로 설계돼 기존 서버에 별도 구조 변경 없이 장착할 수 있는 AI 가속기 형태로 제공된다. RNGD 서버는 RNGD 카드 8장을 탑재한 4U 랙마운트 시스템으로, 시스템 전체 전력 소모는 약 3kW에 그친다. 표준 데이터센터 랙 기준으로 최대 5대를 구성할 수 있으며, 랙당 최대 20페타플롭스(INT8 기준)의 AI 추론 성능을 제공한다.

퓨리오사AI는 이번 양산을 기점으로 엔터프라이즈 고객 대상 본격적인 사업화에 나선다는 계획이다. 이미 국내 대기업 계열사를 포함한 일부 고객이 RNGD 도입을 결정했으며, 글로벌 기업 환경에서의 성능 검증과 상용 채택 사례도 늘어나고 있는 것으로 전해진다.

그간 퓨리오사AI는 하드웨어 안정화와 소프트웨어 스택 고도화에 집중해 왔다. LG의 대형 언어모델 ‘엑사원(EXAONE)’ 적용 사례와 오픈AI의 오픈소스 GPT 계열 모델 시연 등 실제 서비스 환경에서의 운영 경험을 축적한 점이 엔터프라이즈 시장 진입의 기반이 됐다. TSMC와 SK하이닉스 등 주요 글로벌 파트너와의 협력으로 생산과 공급 체계도 안정화했다.

업계가 RNGD 양산을 주목하는 이유는 AI 인프라가 직면한 구조적 한계 때문이다. AI 모델의 연산 수요는 빠르게 증가하지만, 다수 기업의 데이터센터는 기존 랙 규격과 전력 예산을 전제로 운영되고 있다. 최근 확산된 고성능 GPU 중심 인프라는 칩당 600W를 넘는 소비전력으로 인해 전력과 냉각 설비 증설 부담을 키우고 있다는 지적을 받아왔다.

이런 상황에서 RNGD는 공냉식 환경과 표준 랙을 유지한 채 AI 추론 성능을 확장할 수 있는 선택지로 제시된다. AI 추론에 특화한 자체 아키텍처를 적용해 동일한 공간과 전력 조건에서 GPU 기반 시스템 대비 약 2.5배 높은 랙당 연산 밀도를 제공한다는 설명이다. 이는 데이터센터의 총소유비용(TCO)을 낮추면서 AI 서비스 확장을 가능하게 하는 구조다.

백준호 퓨리오사AI 대표는 RNGD 양산과 관련해 글로벌 시장에서의 매출 확대에 집중하겠다는 입장을 밝혔다. GPU 중심 구조가 주도해 온 AI 인프라 시장에서 엔터프라이즈 추론 영역을 중심으로 NPU 기반 대안이 어느 정도 입지를 확보할 수 있을지 주목된다.

- 서재창 기자 chang@chosun.com