“GPU 재부팅 원인까지 추적” 15년 협력으로 안정성 확보

오픈AI, 수십만 칩 클러스터 가동… 엔비디아도 AWS 사용

-

“아마존웹서비스(AWS)는 엔비디아 그래픽처리장치(GPU)를 사용하기 최적의 장소다.”

맷 가먼 AWS 최고경영자(CEO)가 2일(현지시각) 미국 라스베이거스에서 열린 ‘AWS 리인벤트 2025’ 기조연설에서 강조한 말이다. 그는 이번 연설에서 엔비디아 최신 GPU ‘GB200 NVL72’를 탑재한 ‘EC2 P6e’ 인스턴스 출시를 발표하며 AI 개발 지원군으로서의 선도적인 역할을 약속했다.

◇ 최신 GB200 탑재 P6e 출시… 올해 나온 P6은 B200·B300

AWS는 이날 엔비디아 최신 GPU 라인업을 탑재한 클라우드 서버를 공개했다.

이번에 새로 발표한 ‘P6e’ 인스턴스는 엔비디아의 최신 GPU ‘GB200 NVL72’ 시스템을 탑재했다. GB200은 엔비디아가 올해 공개한 블랙웰 아키텍처 기반 최신 칩이다. 가먼 CEO는 “가장 까다로운 AI 워크로드를 위한 최고 수준의 컴퓨팅 파워를 계속 제공한다”고 강조했다.

올해 초 출시한 ‘P6’ 인스턴스는 엔비디아 블랙웰 프로세서 ‘B200’과 ‘B300’을 탑재했다. P6 울트라서버는 이전 세대인 P5와 비교해 컴퓨팅 성능이 20배 이상 향상됐다. 대규모 AI 모델 학습과 추론 작업에 적합하다.

다만 AWS는 P6e의 구체적인 성능 수치나 가격, 정확한 출시 일정 등 세부 사항은 공개하지 않았다.

◇ “GPU 재부팅 원인까지 추적, 세부사항이 차이 만들어”

가먼 CEO는 이번 발표에서 AWS가 ‘엔비디아 GPU를 가장 잘 운영할 수 있는 곳’이라고 자신하는 이유를 구체적으로 설명했다. 가장 강조한 부분은 ‘안정성’이다.

그는 “대규모 GPU 클러스터를 다른 클라우드 제공업체에서 운영해본 사람들에게 물어보면, AWS가 단연 가장 안정적이라고 말할 것”이라며 “우리는 노드 장애를 훨씬 잘 방지하고 최고의 신뢰성을 제공한다”고 말했다.

특히 세세한 부분까지 관리한다는 점을 강조했다. “GPU 재부팅을 방지하기 위한 버스 디버깅 같은 사소한 것까지 신경 쓴다”며 “다른 곳에서는 ‘GPU가 원래 그렇다’며 그냥 넘어가지만, 우리는 모든 GPU 재부팅 사례를 조사하고 근본 원인을 파악한다”고 설명했다.

그는 “이런 세부사항이 정말 중요하다”며 “엔비디아와 긴밀히 협력해 지속적으로 개선하고 있고, 이것이 우리가 업계에서 GPU 신뢰성을 선도하는 이유”라고 덧붙였다.

AWS와 엔비디아의 협력은 15년 이상 이어져왔다. 가먼 CEO는 “AWS가 클라우드에서 엔비디아 GPU를 최초로 제공했다”며 “15년 넘게 협력하면서 GPU를 대규모로 운영하는 방법을 터득했다”고 말했다.

◇ 오픈AI, AWS에서 수십만 GPU 가동… 엔비디아도 사용

실제로 글로벌 주요 AI 기업들이 AWS의 엔비디아 GPU 인프라를 대규모로 사용하고 있다. 대표 사례가 오픈AI다. 가먼 CEO에 따르면 오픈AI는 현재 AWS에서 수십만 개의 칩으로 구성된 울트라서버 클러스터를 가동하고 있다. 여기에는 B200과 GB300 등 엔비디아 최신 GPU들이 포함된다.

오픈AI는 이 인프라로 챗GPT 서비스를 운영하고 있으며, 동시에 차세대 AI 모델을 학습시키고 있다. 가먼 CEO는 “오픈AI는 에이전트 워크플로를 관리하기 위해 수천만 개의 CPU로 확장할 수 있는 능력을 갖췄다”고 설명했다.

엔비디아 자체도 AWS 고객이다. 가먼 CEO는 “엔비디아가 자사의 대규모 생성형 AI 클러스터 ‘프로젝트 세바(Project Seva)’를 AWS에서 운영하고 있다”고 밝혔다. GPU 제조사가 클라우드 인프라로 AWS를 선택했다는 점을 강조한 것이다.

-

◇ 자체 칩 개발하면서도 엔비디아와 협력 강화하는 ‘투트랙 전략’

AWS의 전략에서 흥미로운 점은 자체 AI 칩 개발에 박차를 가하면서도 엔비디아와의 협력을 오히려 더욱 강화하고 있다는 점이다.

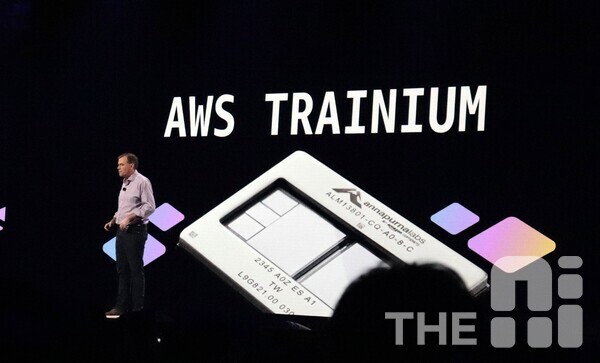

AWS는 이날 자체 개발 AI 칩 ‘트레이니움(Trainium)’ 3세대 제품도 정식 출시했다. 트레이니움은 AI 모델 학습과 추론에 특화된 칩으로, 이미 100만 개 이상이 AWS 데이터센터에 배치됐다. AWS의 AI 플랫폼인 ‘아마존 베드록’에서 제공되는 추론 작업 대부분이 트레이니움에서 처리되고 있다.

가먼 CEO는 “AI 인프라를 생각할 때 가장 먼저 떠올리는 것이 GPU”라며 “AWS는 고객에게 가장 확장 가능하고 강력한 AI 인프라를 제공하기 위해 하드웨어부터 소프트웨어까지 모든 레이어를 최적화하고 있다”고 말했다.

자체 칩으로 가격 경쟁력을 높이면서도, 엔비디아 GPU를 원하는 고객들에게는 최고 수준의 안정성을 제공한다는 ‘투트랙 전략’을 실행하고 있는 것이다. 가먼 CEO는 “고객에게 선택권을 제공하는 것이 AWS의 철학”이라고 강조했다.

- 미국 라스베이거스=김동원 기자 theai@chosun.com