-

6월 초 이재명 정부가 출범하면서 국내 인공지능(AI) 산업계도 큰 변화의 조짐을 체감하고 있다. 초대 AI미래기획수석에 하정우 네이버 AI 이노베이션센터장이, 과학기술정보통신부 장관 후보로는 배경훈 LG AI연구원장이 각각 발탁됐다. 두 인물 모두 초거대 언어모델 개발을 이끌어온 상징적인 인사다. 하 수석은 네이버의 하이퍼클로바(HyperClova) 개발을 주도했고, 배 후보는 국제적으로 인정 받고 있는 LG의 엑사원(Exaone)을 통해 국내 초거대 AI의 가능성을 입증했다. 현 정부의 기조는 명확하다. '소버린 AI(주권 AI)'이다. 쉽게 풀어쓰자면 우리도 우리만의 경쟁력 있는 AI 기술, 데이터, 시스템, 인력 등을 가져야 한다는 것이다.

최근 정부는 전임 정부의 ‘월드베스트 LLM(World Best LLM)’이라는 다소 과감한 사업명을 ‘독자 AI 파운데이션 모델(이하 독자 모델)’로 변경하여 사업 공고를 냈다. 글로벌 경쟁력이 있는 AI 모델을 국내 독자 기술로 개발하겠다는 의지를 명확히 한 것으로 보인다.

파운데이션 모델이란 처음부터 방대한 양의 데이터를 바탕으로 학습시킨 범용 인공지능 모델을 말한다. 이에 비해 파인튜닝 모델은 이미 학습된 파운데이션 모델을 특정 목적에 맞춰 소량의 데이터로 추가 학습하는 방식으로 만들어진다. 비유하자면 파운데이션 모델은 백지에서 시작하는 대작 회화이고, 파인튜닝은 그 위에 덧칠하는 작업이다. 기술적 난도, 소요 시간, 데이터 요구량, 소요 자원, 예산 모두에서 수십 배 이상 차이가 난다. 아무나 도전할 수 없는 영역이다.

소버린 AI의 필요성과 방향성은 여전히 논의의 여지가 있다. 그러나 국방이나 안보 등 안전과 관련된 국가 전략 자산의 영역에서 기술 자립이 중요하다는 것은 누구도 부인하기 어려울 것이다. 그런 점에서 이번 독자 모델 프로젝트는 단지 기술 개발을 넘어, ‘AI 안전성’이라는 화두를 본격적으로 공론화할 수 있는 계기가 되기를 희망한다.

-

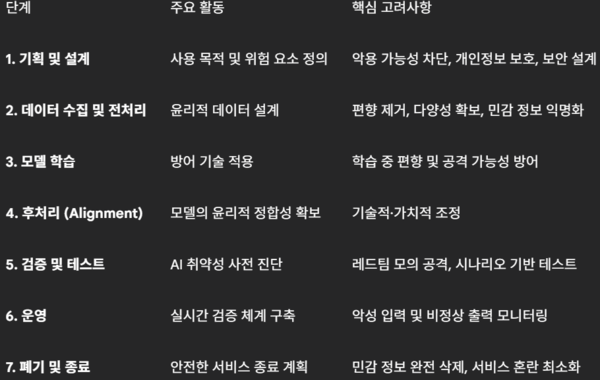

AI의 안전성은 기획부터 폐기까지, 전 생애주기에 걸쳐 고려되어야 한다. 그 주요 단계는 △기획 및 설계 △데이터 수집 및 전처리 △모델 학습 △후처리 △검증 및 테스트 △운영 단계 △폐기 및 종료 등 7단계로 나뉜다.

이 가운데 특히 2·5·6 단계가 중요하다.

우선 2단계인 데이터 수집 및 전처리는 법적, 윤리적 이슈와 직결된다. 이미 해외에서 우리는 수많은 사례를 접한 바 있다. 유수의 언론사들이 AI 개발 기업들의 무단 크롤링을 문제 삼고 있고, 예술가들은 AI 이미지 생성 모델들이 자신들의 작품을 무단 학습에 사용했다며 소송을 제기하고 있다. 국가 주도의 모델 개발이라면 이 문제를 더 심각하게 생각해야 한다. 법령 정비와 공론화, 예산 확보가 선행되어야 한다.

그나마 다행인 점은, 우리나라는 2020년부터 한국지능정보사회진흥원(NIA)을 중심으로 다량의 양질 데이터를 구축해 왔다는 것이다. 데이터 댐 사업이 그것이다. 이 데이터는 이번 독자 모델 프로젝트에도 활용될 가능성이 크다. 하지만 데이터가 방대한 만큼 데이터의 신뢰성이나 안정성 검증이 쉽지 않다. 그 많은 데이터를 사람이 일일이 눈으로 살필 수도 없는 노릇이다. 몇 해 전, NIA 데이터의 일부를 필자가 속한 스타트업의 자체 가드레일 솔루션으로 검토한 결과, 적지 않은 윤리적 문제를 확인한 바 있다. 기존 데이터는 물론 향후 수집할 데이터들도 사정은 마찬가지일 터이니, 자동화된 데이터 윤리 검증 도구를 도입해 신뢰성을 확보할 필요가 있다.

5단계인 검증 및 테스트는 기술보다 ‘철학’의 영역과도 맞닿아 있다. 오픈AI는 챗GPT를 출시하기 전 수많은 인력을 투입해 모델의 반응을 검토하고 조정했다. 그러나 상업화 압박 속에서 이런 안전성 테스트는 점차 생략되거나 약화되었고, 이는 내부 반발과 경영진 충돌로 이어졌다. 구글도 성급한 출시로 인해 AI 이미지 생성 결과가 과도하게 정치적 올바름(PC)에 치우쳐 조롱의 대상이 되기도 했다.

우리는 반복된 역사에서 배워야 한다. 단순히 ‘사람’ 중심의 레드팀이 아니라, 모델 자체를 공격하고 점검하는 ‘시뮬레이션 기반 자동 레드팀’ 체계 구축이 필요하다. 창과 방패를 동시에 만드는 것이다.

끝으로 6단계인 운영 단계는 기술과 철학이 만나는 지점이다. 아무리 설계를 잘해도 현실에서는 예기치 못한 상황이 발생한다. 사용자 입력의 악의성을 구분하고, 모델 출력을 선별적으로 제한하면서도 표현의 자유를 침해하지 않도록 조율하는 일은 그 자체로 고도의 기술과 감수성을 요한다.

더욱이 사람들은 같은 내용이라도 인간이 말하면 이해하지만, AI가 말하면 받아들이지 못하는 이중 잣대를 갖기 쉽다. AI가 ‘윤리적 중립’을 지켜야 한다는 기대는 오히려 인간보다 더 완벽한 존재가 될 것을 요구하는 셈이다. 이처럼 인간과 AI의 윤리 기준에 대한 사회적 합의가 선행돼야 한다.

국내 AI 산업은 지난 몇 년간 정체기를 겪어왔다. 대기업도, 스타트업도, 투자자도 어려운 시기를 견뎌야 했다. 그러나 지금 다시 흐름이 바뀌어 막혀 있던 혈이 돌기 시작한 느낌이다. 모쪼록 이번 독자 모델 프로젝트가 단지 기술의 진보를 넘어서, 우리가 어떤 AI를 만들고 어떻게 책임질 것인가에 대한 논의의 출발점이 되기를 기대한다.

박규병은 인공지능 스타트업 튜닙 대표로 전 카카오브레인 자연어처리팀장으로 일했다. 언어와 컴퓨터를 공부한 지난 10년을 바탕으로, 인공지능으로 ‘어떻게 대박을 낼 것인가’를 고민하며 4년을 보냈고 최근 4년은 사람과 AI 캐릭터가 공존하는 새로운 SNS 서비스를 만들기 위해 분투 중이다.

- 박규병 튜닙 대표 ryan.ai@tunib.ai