AI 규제 마련 국제적 협력 강화 강조

THE AI 주최 ‘Good AI 어워드’서도 AI 안전성 기여 수상

-

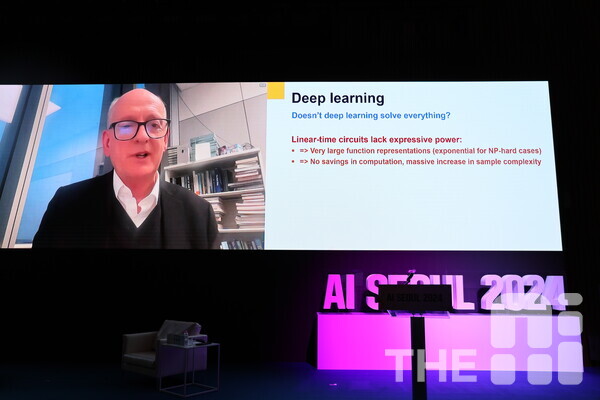

세계적인 AI 석학 스튜어트 러셀(Stuart Russell) UC버클리 전기공학·컴퓨터과학 교수가 올해는 ‘안전한 인공지능(AI) 실전의 해’라고 주장했다. 1일 서울시청 다목적홀에서 열린 ‘인공지능(AI) 서울 2024’ 기조연설자로 나서 “범용 인공지능(AGI·Artificial General Intelligence)이 발전하면 인간의 통제력은 상실될 수 있다”며 “우리가 달성해야 하는 목표는 설명가능한 AI”라고 밝혔다. 이어 “AI를 안전하게 만드는 것이 아닌 안전한 AI를 만들어야 한다”며 “지난해는 AI에 대해 많은 것을 깨닫는 해였고, 올해는 세계 모두가 신뢰할 만한 AI를 위해 행동해야 하는 시기”라고 강조했다.

스튜어트 러셀 교수는 ‘AI 교과서’로 불리는 그의 저서 ‘어떻게 인간과 공존하는 인공지능을 만들 것인가’를 통해 AI 위험에 대한 화두를 던졌다. '인간과 공존하는 인공지능을 위한 센터(Center for Human-Compatible AI)'의 소장을 맡고 있으며, AI 안전성을 전 세계에 널리 알려왔다. 2021년 엘리자베스 여왕이 수여하는 대영제국훈장(OBE)를 수상했고, 지난해 인공지능국제회의(IJCAI)에서 우수 연구상을 받았다. 국내에선 더에이아이(THE AI)가 주최한 ‘Good AI 어워드 2023’에서 AI의 위험성을 전 세계에 알린 공을 인정받아 글로벌 특별상을 수상한 바 있다.

이날 러셀 교수는 AI가 기하급수적으로 발전하고 있다고 설명했다. 그는 “인간이 원하는 성능에 달할 수 있도록 기계 성능을 최적화하는 범용 AI 시대가 오고 있다”며 “현재 기계가 언어를 학습한 대형언어모델(LLM)을 사람들이 빠르게 사용하고 있고 변화의 속도는 연구자들조차 놀랄 만큼 빠르다”고 말했다.

-

AI의 능력이 과대평가 되고 있는 점도 지적했다. 러셀 교수는 “AI 능력을 사람들이 과대평가하는 경향이 있다”면서 “범용 AI가 구축되면 지구상의 사람들의 삶의 질을 확 개선할 것처럼 기대하고 있다”고 말했다. 물론 경제적인 가치나 삶의 질을 개선하는 데 많은 부분에서 인간을 보조하고 도움을 줄 수 있겠지만 AI가 전부로 치부되어서는 안된다고 당부했다.

그는 통제 가능한 AI 생태계 구축을 위한 3가지 원칙을 제시했다. 대원칙은 인간이 최종 통제권을 가질 수 있도록 설계해야 한다는 것이다. 인간을 보조하고 설계자가 원하는 방식으로 행동하는 AI 시스템을 구축해야 진화한 AI에 대한 통제권을 인간이 유지할 수 있다고 강조했다.

러셀 교수는 현재 가장 활발하게 사용되고 있는 챗GPT와 같은 생성형 AI를 바탕으로 설명했다. 먼저 LLM 모델을 제대로 이해하고 본 시스템 역량을 잘 파악해야 한다고 강조했다. 그다음 전체 시스템이 사람이 원하는 방식으로 작동할 수 있도록 해야 한다고 제언했다. 이어 개별적으로 설명할 수 있을 수 있는 탄탄한 아키텍처로 구성해야 한다고 덧붙였다.

AI 안전에 대한 국제 협력 강화도 강조했다. 러셀 교수는 “글로벌 단위의 AI 안전성에 대한 개념 정립과 협력이 필요하다”면서 “AI 시스템을 규제 기관에 모두 등록하도록 하고 전반적인 안전 증명을 거쳐야 한다”고 했다. 이어 “규제 기관에는 규칙을 위반했을 때 그 기술 없애는 권한이 있어야 하고 의무적으로 개발자들은 자신의 기술이 안전하다는 것을 증명해야할 의무가 있어야 한다”고 설명했다.

올해 서울에서 열리는 제2회 ‘AI 안전 정상회의’도 주목했다. 러셀 교수는 “서울에서 열리는 AI 안전 정상회의에서 공통의 규제 논의가 이뤄질 것”이라고 말했다. 지난해 11월 영국 런던에서 처음 개최된 ‘AI 안전 정상회의’가 6개월 후인 올해 5월 서울에서 열릴 예정이다. 런던 회의에선 28개국 대표들이 모여 AI를 안전하게 개발하기 위한 글로벌 표준을 마련하겠다는 ‘블레츨리’ 선언서를 발표했다. 이 회의는 6개월마다 나라를 옮겨가며 논의된 AI 규제를 확장하는 식으로 진행된다.

- 구아현 기자 ainews@chosun.com